NVIDIA TensorRT-LLM обеспечивает значительный прирост для искусственного интеллекта с GPU GeForce RTX

Дата: 19.10.2023 04:35

Новости о мире нейросетей и ИИ

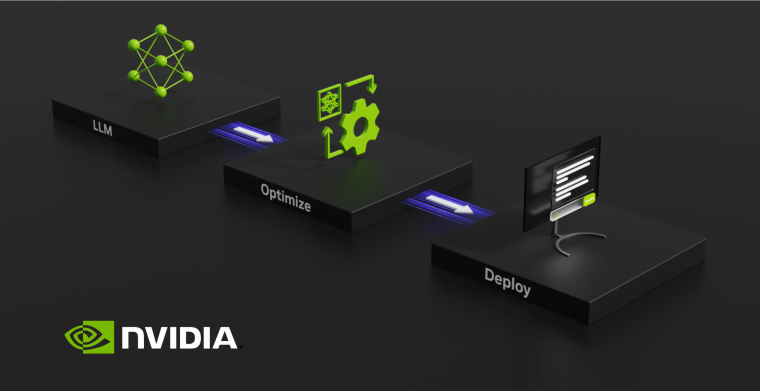

Совместно с поддержкой RTX Video Super Resolution на графических картах серии GeForce RTX 20, NVIDIA представила библиотеку программного обеспечения TensorRT-LLM для Windows. TensorRT-LLM - это библиотека с открытым исходным кодом, специально разработанная для больших языковых моделей, которая уже была внедрена в ускорители для центров обработки данных и доступна в режиме раннего доступа. TensorRT-LLM в очередной раз демонстрирует, что доработка и оптимизация программного обеспечения могут иметь такой же важный эффект на производительность больших языковых моделей, как и новые ускорители.

С помощью TensorRT-LLM на Windows пользователи с графическими картами GeForce RTX смогут воспользоваться преимуществами оптимизации. Локальный вывод больших языковых моделей с использованием TensorRT-LLM в четыре раза быстрее, чем без этой библиотеки программного обеспечения.

TensorRT-LLM также обеспечивает преимущество производительности для локального обучения. Большие языковые модели терпят неудачу, когда им приходится отвечать на вопросы или выполнять задачи, на которые они на самом деле не знают ответа, то есть за пределами объема данных, использованных для обучения. В таких случаях большие языковые модели подвержены фальсификации - они просто придумывают ответ на основе неверных данных. Эту проблему решает технология Retrieval-Augmented Generation (RAG), которая предоставляет контекст вместе с вопросом/деталями задачи. Ее также ускоряет использование TensorRT-LLM.

В скором времени библиотека TensorRT-LLM для Windows будет доступна на веб-сайте разработчиков NVIDIA. Оптимизированные модели с открытым исходным кодом и демонстрационные материалы RAG будут доступны по адресам ngc.nvidia.com и github.com/nvidia.